Idioma

You can read the magazine in one of the following languages

Geolocalización

Puedes leer el contenido global o el de tu regió

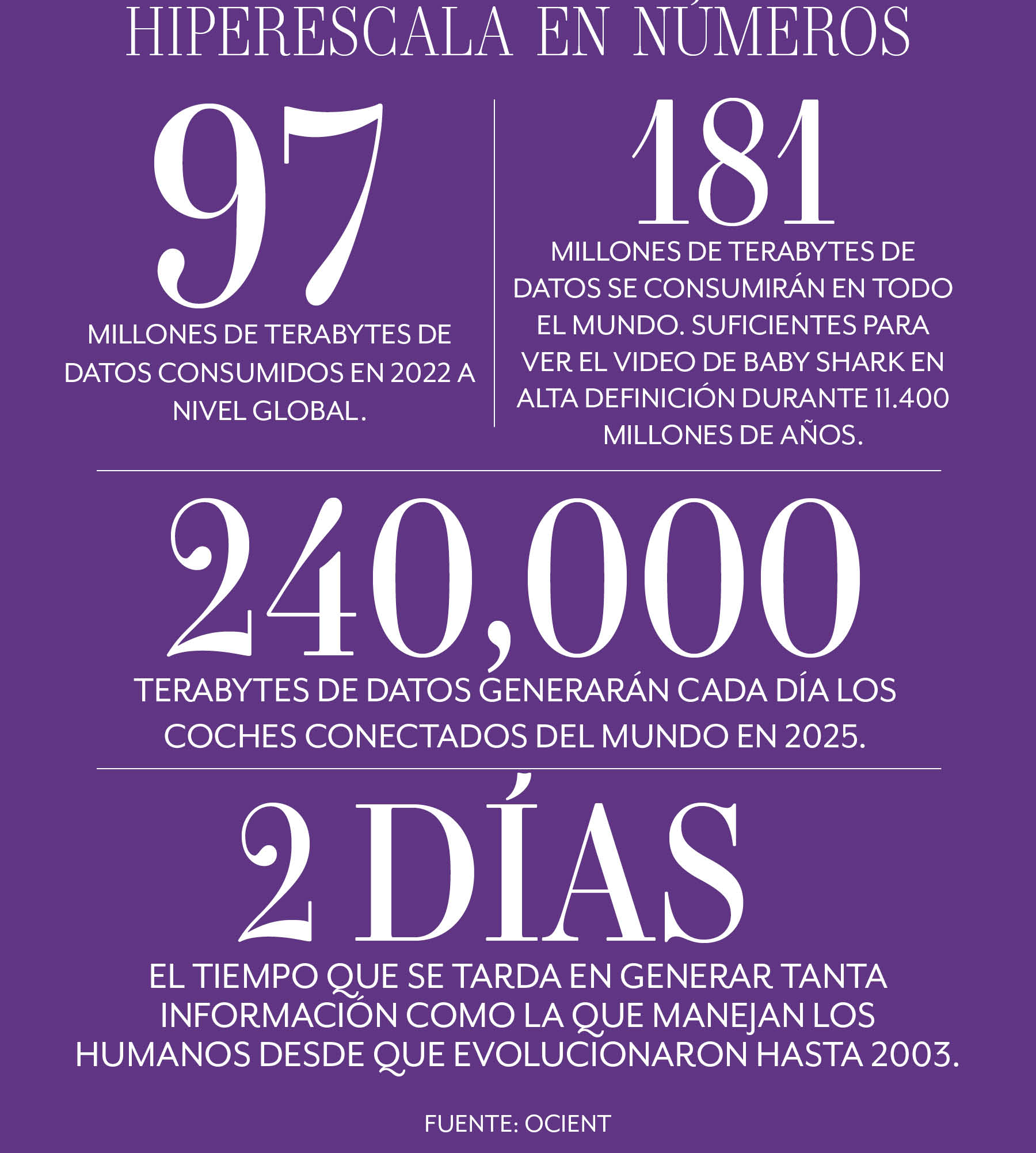

La magnitud de los datos que se generan es casi incomprensible. Ya sea que se midan en gigabytes, terabytes u otros términos cada vez más grandes, lo único que hay que saber es que son muchos y que se duplican cada 1.2 años. De hecho, el 90 por ciento de todos los datos producidos por el ser humano se han creado desde que comenzó la pandemia en 2020.

Atrás quedaron los días en que el big data se consideraba grande. Hoy en día, el tsunami de información que recorre el planeta se conoce como la «revolución de la hiperescala».

Los datos están en todas partes.

Por la mañana, tu tostadora inteligente utilizará complejos algoritmos para conseguir el tono de marrón preciso que se adapte a tus gustos utilizando la menor cantidad de energía. Mientras lo hace, tu bandeja de huevos inteligente (sí, existe algo así) se sincroniza con tu teléfono y te confirma que quedan cuatro huevos y que todos están todavía frescos.

Mientras tanto, tu iKettle activado por voz ha previsto que la preparación del té es inminente y ha hervido el agua suficiente para tu taza.

Sólo por tomar una tostada con huevo frito y una taza de té por la mañana, ya has generado unos cuantos miles de kilobytes de datos, y eso antes de que tu auto inteligente empiece a producir 25 megabytes por hora mientras te diriges al trabajo, pasando por varios cientos de cámaras de vigilancia debidamente advertidas de tu presencia.

Para las empresas, la hiperescala abre un vertiginoso -y abrumador- abanico de posibilidades que incluyen el marketing ultrapersonalizado, la mejora de los productos y el mapeo de clientes. Las sofisticadas aplicaciones de aprendizaje automático pueden ejecutar millones de simulaciones para optimizar la eficiencia y realizar un seguimiento de las compras de los consumidores, probando correlaciones aparentes para establecer la causalidad y generando sugerencias de estrategias optimizadas.

Así que invertir en un conjunto de artilugios de análisis de datos para impulsar tu empresa es una obviedad. Sin embargo, eso no significa que sea pan comido, ya que elegir la opción equivocada podría ser el equivalente corporativo a un pan tostado que se quemó.

Y si no se puede filtrar la información inútil, intentar darle sentido es como beber de una manguera para apagar incendios.

En otras palabras, no se trata de cuánto sabes, sino de su habilidad para procesarlo en conocimiento y luego destilarlo en inteligencia útil.

Y es muy importante que lo hagas, ya que la capacidad de analizar rápidamente grandes conjuntos de datos está directamente relacionada con el éxito empresarial, según una importante encuesta de Ocient, especialista en datos, realizada en 2022 entre directivos de empresas.

«El mundo va más allá de los macrodatos», concluye la encuesta. «Las empresas más grandes del mañana no solo recopilarán y almacenarán billones de filas de datos, sino que necesitarán realizar análisis continuos y complejos de datos a hiperescala, utilizando tecnología para ejecutar miles o incluso millones de consultas cada hora, las 24 horas del día», puntualiza.

Según Viktor Mayer-Schoenberger, catedrático de Gobernanza y Regulación de Internet en la Universidad de Oxford, una medida clave del éxito de las empresas que persiguen un futuro basado en los datos es darse cuenta de que no todos los datos son iguales.

«El pensamiento convencional dice que necesitamos recopilar muchos datos de muchas fuentes o individuos diferentes para captar la realidad y hacer buenas predicciones», dice a The CEO Magazine. «Pero eso sigue estando demasiado centrado en la situación media», explica.

El autor del influyente libro Big Data: A Revolution That Will Transform How We Live, Work, y Think predice que en el futuro las empresas tendrán que evitar la tentación de generalizar.

«Tendremos que recoger datos de un individuo concreto y utilizarlos localmente para ofrecerle predicciones. En otras palabras, el análisis de datos se vuelve hiperlocal e hipercontextual, lo que conduce a mejores predicciones y decisiones», agrega.

¿Qué empresas están encontrando con más éxito nuevas formas creativas de aprovechar los datos a hiperescala y qué podemos aprender de sus esfuerzos? Las siguientes empresas han liderado la construcción de modelos únicos basados en datos que les han proporcionado ventajas competitivas cruciales y han ampliado los límites de lo posible.

A medida que los líderes empresariales se daban cuenta del potencial casi ilimitado de la IA, la analítica de datos -que antes estaba reservada al pálido personal de contabilidad en oficinas grises y sin ventanas- se volvió sexy de repente, y en ningún sitio sucedió a tal grado como pasó con el gigante de los deportes.

Los informáticos de su sede de Gurugram, cerca de Delhi, por ejemplo, disfrutan de un espacio de trabajo ergonómico con un diseño espacial inteligente, zonas de descanso, sacos de boxeo y «avenidas de movilidad».

Por eso no sorprende que Adidas se haya apresurado en adoptar el rendimiento basado en datos; tanto dentro como fuera de la pista; comprometiéndose a invertir 1,000 millones de dólares en investigación y digitalización en los próximos dos años.

La clave para ello será hacer todo lo contrario a muchas empresas: descentralizar su almacenamiento de información y convertirlo en «redes de datos» en la que cada dominio tenga la propiedad.

«Adidas ha conseguido democratizar el acceso a los datos», afirma el director de Ingeniería de Plataformas de la firma, Javier Pelayo. «Esto es sólo el principio de un largo camino. La primera prioridad es detectar y atajar los cuellos de botella que ponen en peligro la autonomía de las distintas unidades», agrega.

Pelayo también aboga por el uso de lagos de datos, diferentes de los almacenes o las bases de datos, ya que contienen datos históricos sin procesar, para un análisis más rico y contextualizado.

En 2016, el gigante del software en la nube, Salesforce, lanzó su innovador motor de IA, Einstein, para proporcionar gestión de relaciones con los clientes y solucionar prácticamente cualquier necesidad corporativa, actualizándolo y mejorándolo cada año, e incluso construyendo un Modelo de Madurez Ética de IA para ESG.

«Estamos al principio de una transición de la inteligencia artificial desde la maximización de la precisión a los objetivos de inclusión y responsabilidad», explica a The CEO Magazine Rowena Westphalen, vicepresidenta sénior de las operaciones de la empresa en ASEAN y ANZ.

«Estos objetivos se convertirán en componentes críticos del capitalismo y de la creación de confianza, lo que significa que las empresas estarán mejor situadas para utilizar la IA de forma segura, precisa y ética», agrega.

El gigante bancario británico se asoció con la empresa de IA Simudyne para crear situaciones bancarias simuladas utilizando sus propios datos transaccionales, lo que le permite adaptar el aprendizaje automático a un razonamiento cognitivo sofisticado que puede utilizarse para el procesamiento del lenguaje natural (PLN), es decir, una forma de interpretar las voces de los clientes o los mensajes escritos utilizando pistas contextuales, tal y como lo hace un ser humano.

IBM reflexionó por primera vez sobre el concepto de aprendizaje por computadora en la década de 1950, pero fue una hazaña en 2011 la que lo situó en primera línea, en el competitivo espacio de dar respuesta a preguntas por medio de IA.

IBM Watson se había desarrollado como la mejor herramienta de razonamiento automatizado y PNL del sector, y se enfrentó a los dos concursantes con mayor puntuación de la historia del concurso televisivo Jeopardy. En medio de un frenesí mediático, se impuso a ambos, demostrando una capacidad inédita para procesar el lenguaje hablado y elaborar respuestas.

Incluso dio lugar a un debate filosófico sobre si Watson era capaz de pensar. En cualquier caso, pronto fue capaz de procesar datos a hiperescala y, en poco tiempo, tres cuartas partes de las instituciones bancarias mundiales ya lo utilizaban, al tiempo que hacía incursiones considerables en otros sectores como la moda, la predicción meteorológica y la atención sanitaria.

En 2022, IBM ya facturaba más de 1,000 millones de dólares, pero a medida que sus rivales se adentraban en el sector, la empresa seguía luchando por obtener beneficios, lo que, irónicamente, ponía en peligro su futuro.

Una empresa australiana de servicios financieros encontró nuevas formas de utilizar la IA a través de Google Cloud para reducir radicalmente el costo del asesoramiento financiero y los recursos necesarios para el cumplimiento de la normativa, con el fin de aprovechar el vacío que quedó cuando los principales bancos de Australia se retiraron de la gestión de patrimonios hace cuatro años.

Si dichos bancos hubieran sido tan astutos con sus datos como HUB24, probablemente no habrían tenido pérdidas tan desorbitadas.

«La plataforma del futuro consiste en utilizar los datos y la tecnología para impulsar soluciones empresariales transformadoras. Google Cloud es un componente clave», afirma Craig Apps, director de Innovación.

La empresa futurista de Hong Kong gestiona la mayor plataforma de IA del mundo, y recientemente ha aplicado su software patentado de reconocimiento facial a la detección de defectos en el sector de los componentes de automóvil.

También ha liderado el campo de la inteligencia de decisiones, la mejora de contenidos y la protección de datos, y realizó una exitosa oferta pública inicial en 2022, a pesar de estar en la lista negra del gobierno de Estados Unidos por motivos de seguridad y del escrutinio sobre su supuesto papel en la vigilancia de los uigures.

Las acciones han caído bruscamente desde entonces, pero la empresa sigue invirtiendo fuertemente en tecnologías de IA para lograr la neutralidad de carbono en ciudades inteligentes emergentes.

Aunque el valor comercial del metaverso, proyecto de Mark Zuckerberg, sigue siendo cuestionable, la empresa matriz de Facebook está invirtiendo fondos sin precedentes en nuevas tecnologías de datos en el mundo real, para crear perfiles de clientes cada vez más sofisticados que desemboquen en un marketing dirigido con el que otros sólo podrían soñar.

Incluso con más datos personales de clientes que ninguna otra entidad, sigue necesitando más para ayudar a sus algoritmos de aprendizaje automático, a detectar contenidos potencialmente dañinos.

Admitió que simplemente no tenía suficientes puntos de referencia para permitir a sus sistemas de inteligencia eliminar rápidamente vídeos perjudiciales, como los ataques terroristas de Christchurch de 2019, o para hacer frente al creciente volumen de desinformación sobre la pandemia o la política.

Pero hay pocas empresas forzando tanto los límites del aprendizaje profundo. En septiembre del año pasado, Zuckerberg publicó un vídeo recopilatorio de 20 segundos creado íntegramente a partir de breves pasajes de texto para demostrar uno de sus proyectos de IA.

También ha desarrollado descripciones fotográficas generadas automáticamente para ayudar a los invidentes a «ver» imágenes mediante redes neuronales que aprenden del procesamiento de miles de millones de puntos de datos.

Aunque hay numerosas lecciones comerciales que aprender sobre cómo explotar la revolución de la hiperescala, también hay consideraciones morales.

Como reflexionar sobre cuándo el mapeo detallado de los clientes se convierte en un espeluznante ejercicio de acoso virtual.

Para Barry Devlin -que publicó el primer diseño de almacén de datos en 1988 y desde entonces se ha convertido en una autoridad mundial y autor de best sellers sobre la evolución de los macrodatos-, la ética de la IA mejorada y el «capitalismo de la vigilancia» a menudo se dejan de lado en la carrera por un marketing cada vez más dirigido.

«Muchas de las formas en que las empresas y los gobiernos utilizan grandes cantidades de datos son profundamente perjudiciales para la humanidad», afirma a The CEO Magazine.

«El uso de los datos de las redes sociales y de la IA financiado por la publicidad está destruyendo vidas y socavando la confianza de la sociedad hasta el punto de amenazar la democracia y negar los hechos científicos», agrega.

“El uso de datos e inteligencia artificial en las redes sociales financiado por la publicidad está destruyendo vidas y socavando la confianza de la sociedad hasta el punto de amenazar la democracia y negar los hechos científicos”.

- Barry Devlin

«Mientras los algoritmos consumen cada uno de sus clics y las corporaciones extraen hasta la última gota de ingresos publicitarios de su pasado, presente y futuro, eres es poco más que el cadáver de una vida que una vez atesoraste como propia», dice.

Su libro, Business unIntelligence, ha tenido una enorme influencia en el ámbito de la obtención de información a partir de datos a hiperescala, pero aconseja a los líderes empresariales que no ansíen cantidades cada vez mayores por su propio bien.

«Los macrodatos siempre han sido más un bombo publicitario que un avance real en el pensamiento empresarial», afirma. «Tener cada vez más datos tiene un valor limitado y puede incluso causar más problemas a las empresas y a la sociedad», agrega.

«Una información mejor y más amplia, con una comprensión profunda de su contexto, en vez de querer más datos, es donde las empresas globales pueden encontrar un valor real», finaliza.

Sin embargo, por cada conglomerado de empresas exitosas que absorben datos a hiperescala y exigen ese valor, hay muchas que siguen sumidas en una ciénaga de hardware anticuado, liderazgo dogmático y negación de que puedan estar perdiéndose algo.

Para muchos, el obstáculo no es la autopista de la información en sí, sino un problema más cercano.

Una encuesta realizada entre ejecutivos de alto nivel por NewVantage Partners reveló que el principal obstáculo para casi dos tercios de ellos era su personal, y un tercio culpaba al «proceso». Solo el 7.5 por ciento mencionó la tecnología.

No es de extrañar que LinkedIn calificara la ingeniería de IA como la habilidad más demandada de 2022, y no muy lejos, la analítica y la ciencia de datos.

Los macrodatos están ahora tan omnipresentes que hay pocos trabajos en los que no desempeñen un papel cada vez más importante. En todos los aspectos de la vida, la gente tiene que estar atenta tanto a sus oportunidades como a sus peligros. La hiperescala debería estar en el radar de todos.

Sobre todo, si tu bandeja de huevos habilitada conspira con la tetera para robarte la identidad.

La guerra de Ucrania la libran, al menos en parte, plataformas rivales de IA que analizan datos en tiempo real para diseñar estrategias de ataques con drones, campañas de desinformación, apuntar con artillería e interceptar misiles enemigos.

El procesamiento de enormes cantidades de información procedente de miles de fuentes está en el centro de todos los aspectos del conflicto, afirma el jefe de Ciberseguridad y Desarrollo de IA del ejército ucraniano, Pavlo Kryvenko.

«Ahora no puede resolverse con éxito sin el uso de armas de última tecnología, inteligencia moderna, transmisión de datos y sistemas de destrucción [que contengan] inteligencia artificial, al menos en parte», afirma.

«La IA procesa enormes cantidades de datos con extrema rapidez, por lo que se tarda mucho menos en tomar decisiones antes o durante las operaciones. También es mucho más fácil controlar tropas y armas», finaliza.